L’importance que tous les fournisseurs de solutions de lutte contre le blanchiment d’argent (LCB) semblent accorder à l’intelligence artificielle (IA) a augmenté le risque de « IA-washing ». En effet, certains d’entre eux ont tendance à exagérer ou déformer leurs capacités techniques, un phénomène qui attire de plus en plus l’attention des autorités de réglementation. Cependant, l’une des préoccupations majeures est de pouvoir s’appuyer sur une IA explicable qui garantit à la fois la transparence et la compréhension des décisions prises par l’IA.

Dans le domaine de la LCB, l’IA explicable est indispensable pour comprendre comment certaines alertes se déclenchent, les raisons du blocage ou de l’autorisation d’une transaction ou encore les facteurs contribuant à identifier un client à haut risque. Cette transparence aide les établissements financiers à satisfaire aux attentes réglementaires et à instaurer un climat de confiance en permettant aux clients, aux auditeurs et aux autorités de régulation de voir comment et pourquoi leurs décisions fondées sur l’IA sont prises, ce qui réduit le risque de fausse déclaration tout et améliorant la responsabilité.

Toutefois, notre enquête sur l’état de la conformité en 2025 révèle une contradiction intéressante. En effet, même si les établissements semblent comprendre les exigences des autorités réglementaires en matière d’IA, 91 % des personnes interrogées ne voient aucun problème à sacrifier l’explicabilité au profit d’une automatisation et d’une efficacité renforcées, ce qui pourrait entrer en contradiction avec la politique de transparence sur laquelle les régulateurs comptent de plus en plus.

Dans ce contexte, les responsables de la conformité doivent donc trouver des solutions pour s’assurer que leurs outils d’IA répondent à la fois à leurs objectifs de performance et aux attentes des régulateurs.

Qu’est-ce que l’IA explicable (XAI) ?

L’IA explicable (XAI) désigne les systèmes d’IA qui prennent des décisions et expliquent comment et pourquoi ces décisions ont été prises. Il s’agit aussi d’un sous-ensemble de l’IA responsable (RAI). Mais tandis que la RAI concerne l’ensemble des pratiques éthiques et fiables en matière d’IA, la XAI se focalise spécifiquement sur la transparence des systèmes d’IA et l’intelligibilité des décisions prises par ces derniers. Pour l’équipe en charge de la conformité, la XAI est essentielle pour faciliter l’interprétation des résultats générés par l’IA par les différentes parties prenantes qui ont besoin de valider et de faire confiance à ces systèmes.

Pour atteindre ce niveau de transparence, l’équipe Conformité a souvent recours à des techniques de XAI spécifiques, et notamment à :

- Des modèles fondés sur des règles : Également appelés « modèles d’apprentissage automatique en boîte blanche », les modèles simples basés sur des règles appliquent des règles prédéfinies qui les rendent naturellement interprétables. Ainsi, signaler des transactions d’un gros montant est une règle simple que les professionnels de la conformité peuvent ensuite examiner facilement. Cependant, en raison d’un manque de nuance et de souplesse, le taux de faux positifs de ces modèles est estimé à plus de 98 %.

- Une explicabilité a posteriori (post-hoc) : Alors que les modèles en « boîte blanche » offrent plus de transparence en amont, les « modèles en boîte noire » sont plus complexes et ont tendance à fournir une plus grande précision prédictive. Ces modèles nécessitent souvent des méthodes post-hoc qui permettent à l’équipe Conformité de suivre les niveaux de risque à partir de caractéristiques spécifiques telles que le type de transaction ou l’historique du client.

- Des approches hybrides : Associant différentes techniques fondées sur des règles et pilotées par l’IA, les modèles hybrides s’appuient à la fois sur des règles statiques et des algorithmes adaptables qui améliorent la précision de la détection tout en garantissant la transparence. Grâce à cet équilibre, l’équipe Conformité peut identifier les activités suspectes plus subtiles tout en profitant d’explications à la fois claires et accessibles.

Comment la XAI peut-elle améliorer les systèmes de LCB ?

L’un des principaux avantages de la XAI est sa capacité à améliorer la qualité des alertes et à réduire le volume de faux positifs. Les modèles de LCB traditionnels génèrent souvent de gros volumes d’alertes, dont beaucoup sans intérêt, ce qui surcharge l’équipe Conformité et détourne les ressources des risques réels. La XAI fournit quant à elle des informations plus subtiles sur les facteurs sous-jacents de chaque alerte, ce qui permet à un établissement financier d’affiner ses modèles de détection et de prioriser de manière plus fine les cas à approfondir.

En outre, la XAI renforce sensiblement la capacité d’un établissement à auditer et à justifier ses décisions. Ainsi, si un modèle identifie une transaction suspecte, l’IA explicable peut alors expliciter les facteurs qui ont déclenché l’alerte, notamment les caractéristiques des transactions ou le profil de risque historique d’un client. Ce raisonnement détaillé pour chaque alerte améliore la préparation d’un établissement à un audit des autorités réglementaires en permettant à l’équipe Conformité d’expliquer de manière certaine pourquoi une alerte a été déclenchée et comment ses systèmes LCB diminuent le risque d’oubli ou d’erreur.

L’une des utilisations les plus concrètes de la XAI est celle faite par nos détecteurs de fraude avancés. Conçus dans une volonté de transparence vis-à-vis des clients, ces détecteurs ne se contentent pas d’identifier les comportements suspects et ils fournissent aussi des explications claires pour chaque alerte en détaillant les facteurs ayant influencé la décision qui a été prise. Cet outil permet non seulement à nos clients de justifier leurs actions, mais aussi d’être fin prêts à un éventuel audit en répondant de manière transparente aux demandes d’explication des autorités réglementaires concernant telle ou telle alerte.

Iain Armstrong, spécialiste des affaires réglementaires chez ComplyAdvantage

En outre, l’explicabilité des modèles d’IA peut participer à la formation et au perfectionnement de l’équipe en charge de la conformité. En effet, si cette même équipe comprend la logique qui se cache derrière les alertes, elle peut alors mieux analyser les modèles et comprendre plus finement les indicateurs à haut risque. Tout cela contribue à renforcer l’expertise de l’équipe et favorise une approche plus éclairée de la LCB, au-delà des simples résultats fournis par les modèles.

Cependant, la XAI ne se contente pas d’améliorer les fonctions de conformité et de réglementation ; elle joue aussi un rôle crucial dans la création de produits plus performants.

En effet, comme la relation entre la XAI et l’excellence d’un produit se renforce mutuellement, il est difficile d’obtenir un produit de qualité sans se concentrer sur ces éléments. Chez ComplyAdvantage, notre approche de la gestion des risques liés au modèle nous permet non seulement de maîtriser le risque et de fournir une XAI aux clients, mais aussi de jouer un rôle essentiel dans la création de systèmes d’IA de grande qualité qui sont au cœur des meilleurs produits et services de leur catégorie.

Chris Elliot, Directeur de la gouvernance des données chez ComplyAdvantage

Les attentes réglementaires concernant l’IA explicable (XAI)

Le paysage réglementaire entourant l’IA et l’apprentissage automatique ne cesse d’évoluer, ce qui peut être une source d’incertitude pour les établissements cherchant à adopter la XAI. À mesure que les technologies d’IA s’intègrent davantage aux pratiques LCB et de conformité au sens large, les autorités réglementaires du monde entier mettent toujours plus l’accent sur la transparence, l’équité et la responsabilité pour les systèmes basés sur l’IA. Les établissements qui adoptent ces technologies doivent se tenir informés des toutes dernières normes juridiques et des bonnes pratiques qui mettent de plus en plus l’accent sur la XAI.

Les juridictions partagent une préoccupation commune, à savoir veiller à ce que les applications de l’IA soient transparentes et équitables, en particulier dans les secteurs ayant un fort enjeu tels que la LCB.

Union européenne

Considérée comme « la première loi complète sur l’IA au monde », la loi européenne sur l’IA définit les attentes en matière de transparence, de gouvernance et de responsabilité pour les solutions LCB fondées sur l’IA. Entrée en vigueur en août 2024, cette loi européenne exige des établissements financiers qu’ils garantissent la transparence de leurs processus décisionnels et qu’ils soient notamment capables d’expliquer pourquoi certaines transactions ont été signalées comme étant suspectes. En outre, cette même loi souligne l’importance d’avoir de puissants cadres de gouvernance des données qui exigent des données de grande qualité pour réduire au strict minimum les inexactitudes et les biais.

Le Règlement général sur la protection des données (RGPD) de l’UE vient compléter ces normes spécifiques à l’IA en appliquant des contrôles rigoureux de la confidentialité des données qui participent aux objectifs de la XAI. Grâce au « droit à l’explication » édicté dans le RGPD, les personnes ont un droit de regard sur les décisions automatisées qui les concernent, un droit en phase avec les exigences de transparence de la loi européenne sur l’IA.

Les avantages de l’IA explicable (XAI) dans la LCB

À l’heure où les établissements financiers cherchent à renforcer leurs ressources LCB, la XAI offre une série d’avantages uniques pour améliorer les performances opérationnelles et la conformité à la réglementation, et notamment :

- Une réduction de la charge opérationnelle : En améliorant la qualité des alertes et en réduisant le volume de faux positifs, la XAI autorise l’équipe Conformité à concentrer ses efforts sur les risques réels plutôt qu’à passer au crible un gros volume d’alertes ne nécessitant au final qu’une action minimale. Cette rationalisation peut permettre une allocation plus efficace des ressources humaines.

- L’engagement des parties prenantes : La XAI peut améliorer la communication avec les parties prenantes externes telles que les autorités de règlementation et les clients. S’ils peuvent bénéficier d’explications claires sur les raisons derrière chaque décision prise, les établissements financiers peuvent alors participer plus efficacement aux discussions sur les pratiques de conformité et les stratégies de gestion des risques.

- Un soutien à l’amélioration continue : Les connaissances acquises grâce à la XAI contribuent à améliorer en continu les stratégies LCB. En analysant les déclencheurs d’une alerte et les résultats obtenus, les établissements peuvent affiner leurs modèles de détection ainsi que leurs politiques, ce qui favorise une culture d’amélioration permanente de la gestion des risques.

- Une plus grande confiance des clients : Les établissements peuvent renforcer la confiance dans leurs pratiques LCB en s’appuyant sur la XAI. En effet, des prises de décision transparentes rassurent les clients quant à la diligence et l’équité des processus de surveillance de leur établissement financier.

Les défis et limites de la XAI

Si la XAI offre de nombreux avantages, son déploiement n’est pas sans poser de problèmes. En effet, les établissements financiers doivent évoluer dans un paysage complexe de contraintes techniques, réglementaires et opérationnelles pour intégrer efficacement la XAI à leurs cadres de conformité. Il est indispensable que ces établissements maîtrisent ces obstacles pour trouver un équilibre entre transparence et efficacité. Parmi les principaux défis à relever, citons :

- La confidentialité des données : Assurer la confidentialité tout en garantissant la transparence peut s’avérer un exercice délicat. Par exemple, le règlement RGPD en Europe impose des mesures strictes de protection des données auxquelles les établissements doivent se conformer tout en offrant une transparence suffisante vis-à-vis des résultats liés à la XAI, ce qui peut s’avérer compliqué avec les données personnelles.

- Les biais : Si les données utilisées pour entraîner les modèles de XAI sont biaisées ou non pertinentes, les explications générées peuvent perpétuer les biais existants, ce qui donnera des résultats inexacts ou injustes. C’est ainsi qu’en janvier 2024, le Département des services financiers de l’État de New York (NYDFS) s’est inquiété des biais algorithmiques au sein des technologies financières, soulignant ainsi la nécessité de disposer de processus de prise de décision automatisés devant être à la fois équitables et précis.

- La dépendance envers des données de qualité : Les performances de la XAI sont largement tributaires de la qualité et de l’exactitude des données qu’elle traite. Des données de mauvaise qualité peuvent conduire à des explications et à des décisions trompeuses qui nuisent ainsi à la vocation même de la XAI. Pour veiller au bon fonctionnement de leurs systèmes, les établissements doivent donc investir dans des pratiques de gouvernance et de gestion des données.

Comment fonctionne la XAI dans un système de LCB ?

En matière de LCB, il est possible d’intégrer l’explicabilité de différentes manières afin de créer un système transparent et contrôlable, notamment via :

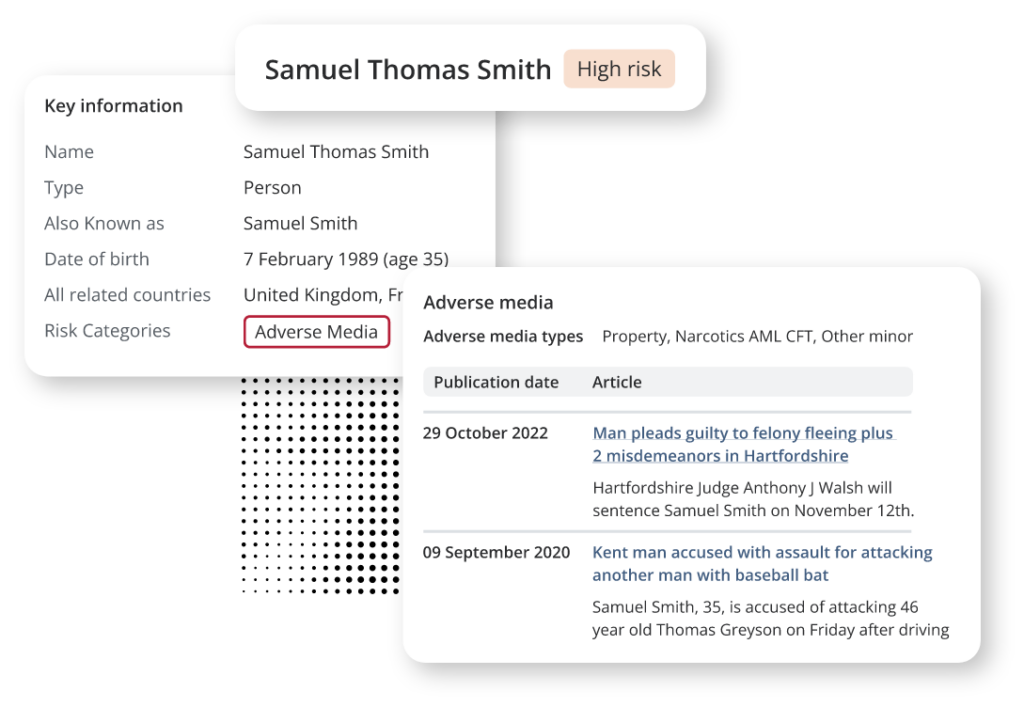

- L’ingestion de données et la résolution d’entités : En consolidant les informations provenant de différentes sources, un système LCB peut fournir une vue complète des entités. Et la XAI peut jouer un rôle clé à ce niveau en clarifiant la manière dont les entités sont identifiées et reliées à des points de données pertinents, qu’il s’agisse de transactions, de relations ou encore d’indicateurs de risque. Supposons, par exemple, qu’une personne soit identifiée comme présentant un risque élevé en raison d’une couverture médiatique négative. Dans ce cas, un système de XAI peut analyser minutieusement ces déclencheurs et aider ainsi l’équipe Conformité à retracer l’origine des données afin de prendre des décisions éclairées.

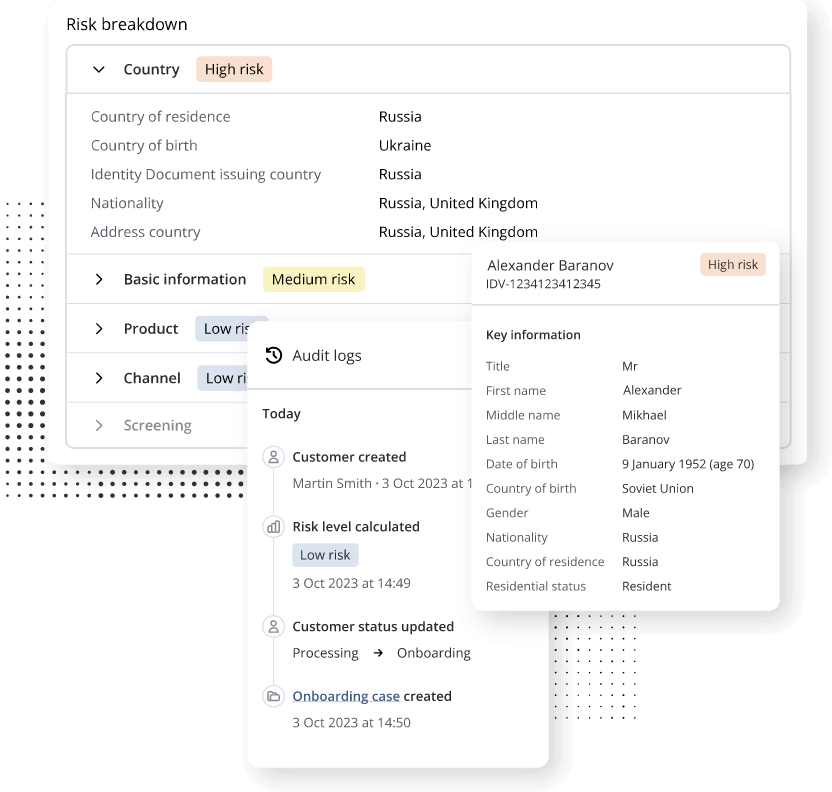

- L’évaluation et la notation des risques : L’évaluation des risques est un élément critique d’un programme LCB qui permet d’évaluer les données pour déterminer le potentiel de risque lié à des entités ou transactions spécifiques. La XAI facilite ce processus en utilisant des modèles explicables pour retracer les facteurs qui déterminent les niveaux de risque. Comme indiqué dans l’image ci-dessous, ces modèles décomposent le risque pour savoir comment des attributs spécifiques participent à l’évaluation globale du risque. Ce niveau de détail est essentiel pour permettre aux responsables de la conformité de prendre des décisions fondées sur des critères transparents.

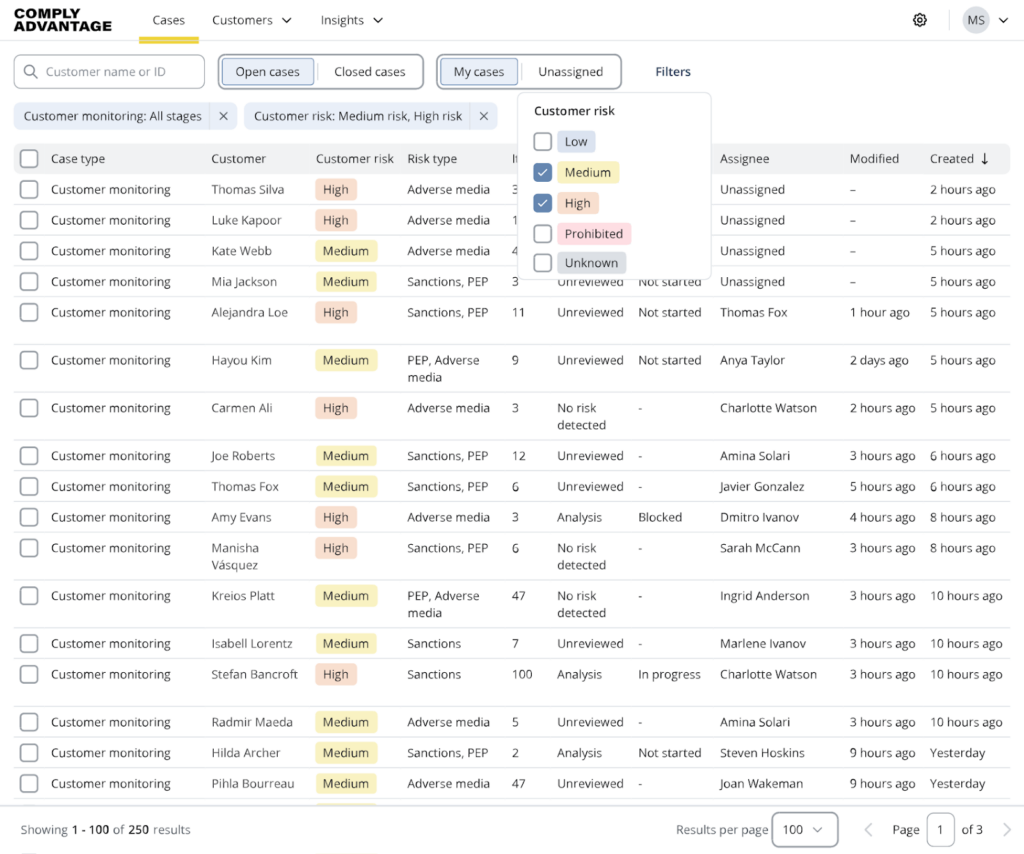

- La génération d’alertes explicables : Lorsqu’un système LCB déclenche une alerte pour une activité potentiellement suspecte, la XAI joue alors un rôle crucial en vérifiant que cette alerte est à la fois précise et accompagnée d’explications claires. Chaque alerte peut contenir des détails sur les indicateurs de risque spécifiques qui ont déclenché l’alerte, ce qui fournit du contexte à l’équipe Conformité et permet des actions de suivi efficaces. Cette transparence est critique pour le reporting réglementaire et pour justifier la décision prise dans la foulée d’une alerte.

5 questions clés à poser à votre fournisseur LCB pour évaluer sa XAI

C’est en posant les bonnes questions que les établissements peuvent mieux évaluer la transparence et la responsabilité des solutions d’IA qu’ils passent en revue. Les questions suivantes peuvent notamment servir de point de départ à la discussion :

- Sur quelles méthodologies votre système d’IA s’appuie-t-il pour prendre des décisions ?

Comprendre les algorithmes et les modèles sous-jacents qu’un fournisseur utilise peut aider à savoir si son IA est explicable. Demandez-lui s’il utilise des systèmes basés sur des règles, des modèles interprétables ou une approche hybride qui associe différentes techniques. S’engager à une méthodologie transparente est un bon indicateur de pratiques XAI. - Comment fournissez-vous des explications pour l’évaluation des risques et les alertes ?

Un fournisseur doit être capable d’expliquer comment son système génère des explications pour les niveaux de risque et les alertes. Demandez-lui de vous montrer comment son système présente ces explications à l’équipe Conformité, et notamment les facteurs spécifiques entrant dans le processus de décision. - Votre système peut-il démontrer la traçabilité des décisions prises par l’IA ?

Un système de XAI puissant doit permettre de retracer ses décisions afin que les professionnels de la conformité puissent analyser la logique derrière les alertes et l’évaluation des risques. Demandez au fournisseur s’il tient un journal détaillé du processus de prise de décision, ce qui peut s’avérer essentiel pour les audits réglementaires et de conformité. - Quelles mesures sont prises pour garantir l’équité et l’exactitude de vos modèles d’IA ?

Il est en effet essentiel de comprendre comment un fournisseur gère les biais et la précision de ses systèmes d’IA. Interrogez-le sur ses sources de données pour entraîner ses modèles, sur la manière dont il garantit la qualité des données et sur les mesures qu’il prend pour atténuer les biais pour la prise de décision. Ceci est d’autant plus pertinent vu l’importance que les régulateurs accordent à l’équité des systèmes automatisés. - Comment gérez-vous les mises à jour et la validation des modèles ?

Une surveillance et une validation permanentes des modèles d’IA sont essentielles pour garantir leur précision et leur fiabilité dans la durée. Les professionnels de la conformité doivent demander au fournisseur comment il procède à l’actualisation et aux tests réguliers de ses modèles et s’il peut expliquer l’évolution des performances de ces derniers.

L’approche de ComplyAdvantage en matière d’IA explicable

L’approche de ComplyAdvantage en matière d’IA responsable, et par extension de la XAI, s’appuie et est alignée sur les principes de l’IA de l’Organisation de coopération et de développement économiques (OCDE) et sur le livre blanc “A pro-innovation approach to AI regulation: government response” publié par le gouvernement britannique et qui souligne l’approche plutôt pro-innovation du Royaume-Uni en matière de réglementation de l’IA. Parmi les cinq principaux thèmes au cœur de notre maîtrise et de notre déploiement d’une IA responsable, deux se rapportent explicitement à la XAI :

- La transparence et l’explicabilité : Nous enregistrons et mettons à disposition des informations sur notre utilisation des systèmes d’IA, y compris concernant l’objectif et les méthodologies utilisées.

- La sûreté, la sécurité et la robustesse : Les décisions prises par nos systèmes d’IA sont explicables et les explications sont consultables et compréhensibles par les parties prenantes concernées, notamment les utilisateurs ou les autorités réglementaires.

Cette approche est au cœur du développement de solutions qui répondent aux attentes des régulateurs, tout en fournissant des informations utiles.

ComplyAdvantage estime que développer et gérer des ressources d’IA de manière responsable est non seulement la bonne solution, mais aussi un moyen d’améliorer les produits impliquant l’IA. La RAI est plus efficace lorsqu’elle est envisagée comme une bonne pratique et qu’elle est plus performante pour nos clients et leurs propres clients. En s’alignant sur les besoins liés à l’activité, elle n’est pas une force extérieure qui agit sur des processus existants et qui entre en concurrence avec d’autres priorités.

Chris Elliot, Directeur de la gouvernance des données chez ComplyAdvantage

Pour plus d’informations sur l’approche de ComplyAdvantage en matière de gestion des risques liés au modèle, vous pouvez lire la déclaration complète ici (en Anglais).

Obtenez une vue à 360 degrés des risques de criminalité financière avec ComplyAdvantage Mesh

Une plateforme de conformité basée sur le cloud, ComplyAdvantage Mesh combine des renseignements de pointe sur les risques LCB avec des signaux de risque exploitables pour filtrer les clients et surveiller leur comportement en temps quasi réel.

Obtenez une démonstrationPublié initialement 09 janvier 2025, mis à jour 11 février 2025

Avertissement : Ce document est destiné à des informations générales uniquement. Les informations présentées ne constituent pas un avis juridique. ComplyAdvantage n'accepte aucune responsabilité pour les informations contenues dans le présent document et décline et exclut toute responsabilité quant au contenu ou aux mesures prises sur la base de ces informations.

Copyright © 2026 IVXS UK Limited (commercialisant sous le nom de ComplyAdvantage)